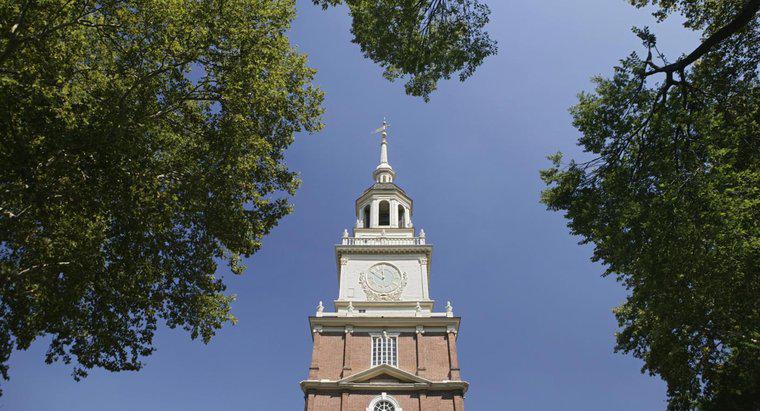

Les États-Unis sont devenus un pays le 4 juillet 1776, lorsque le Congrès continental a officiellement approuvé la Déclaration d'indépendance. Cependant, la première fois qu'un pays étranger a officiellement reconnu les États-Unis comme indépendants, c'était en 1777, lorsque le Maroc a reconnu l'indépendance des États-Unis.

En 1778, la France a reconnu les États-Unis en tant que nation souveraine lorsque des représentants des deux pays ont signé le traité d'amitié et de commerce et le traité d'alliance. La prochaine grande puissance à reconnaître les États-Unis en tant que nation fut le Danemark en 1781. La Grande-Bretagne, bien que se rendant en 1781 aux États-Unis, ne reconnut officiellement les États-Unis comme souverain qu'à la signature du traité de Paris en 1783.< /p>