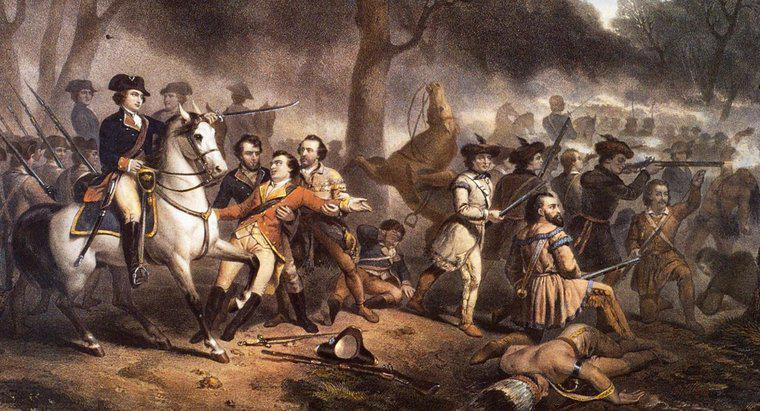

Le traité de Paris a mis fin à la guerre franco-indienne qui a eu lieu entre la Grande-Bretagne et la France. Il a également culminé lorsque la Grande-Bretagne a pris le contrôle des colonies d'Amérique du Nord.

Le traité de Paris a cédé toutes les colonies françaises d'Amérique du Nord à la Grande-Bretagne, mettant fin à toute nouvelle menace de la France sur le continent. L'Espagne, alliée de la France, a donné la Floride à la Grande-Bretagne en échange de Cuba. L'Espagne a conservé le port de la Nouvelle-Orléans et a repris les territoires français à l'ouest du fleuve Mississippi. Toutes les autres colonies d'Amérique du Nord sont devenues britanniques. Les Français ont gardé trois îles des Caraïbes : la Martinique, Sainte-Lucie et la Guadeloupe.

La partie qui a le plus perdu avec le traité n'était ni les Britanniques, ni les Français, ni les Espagnols ; c'était les Amérindiens. Pendant la guerre, les Amérindiens ont joué des deux côtés pour tenter de préserver leurs propres terres et leur propre peuple. Après la signature du traité, ils n'avaient plus cette option.

Le traité de Paris a finalement abouti à l'indépendance des colonies américaines. La France n'étant plus une menace pour la Grande-Bretagne en Amérique du Nord et l'Espagne au loin, la Grande-Bretagne a retiré nombre de ses soldats du continent. De plus, les colons n'avaient plus à dépendre des Britanniques pour se protéger des Français.